RSF e a Regulamentação da IA no Brasil: O que Prestadores de Serviço Precisam Saber

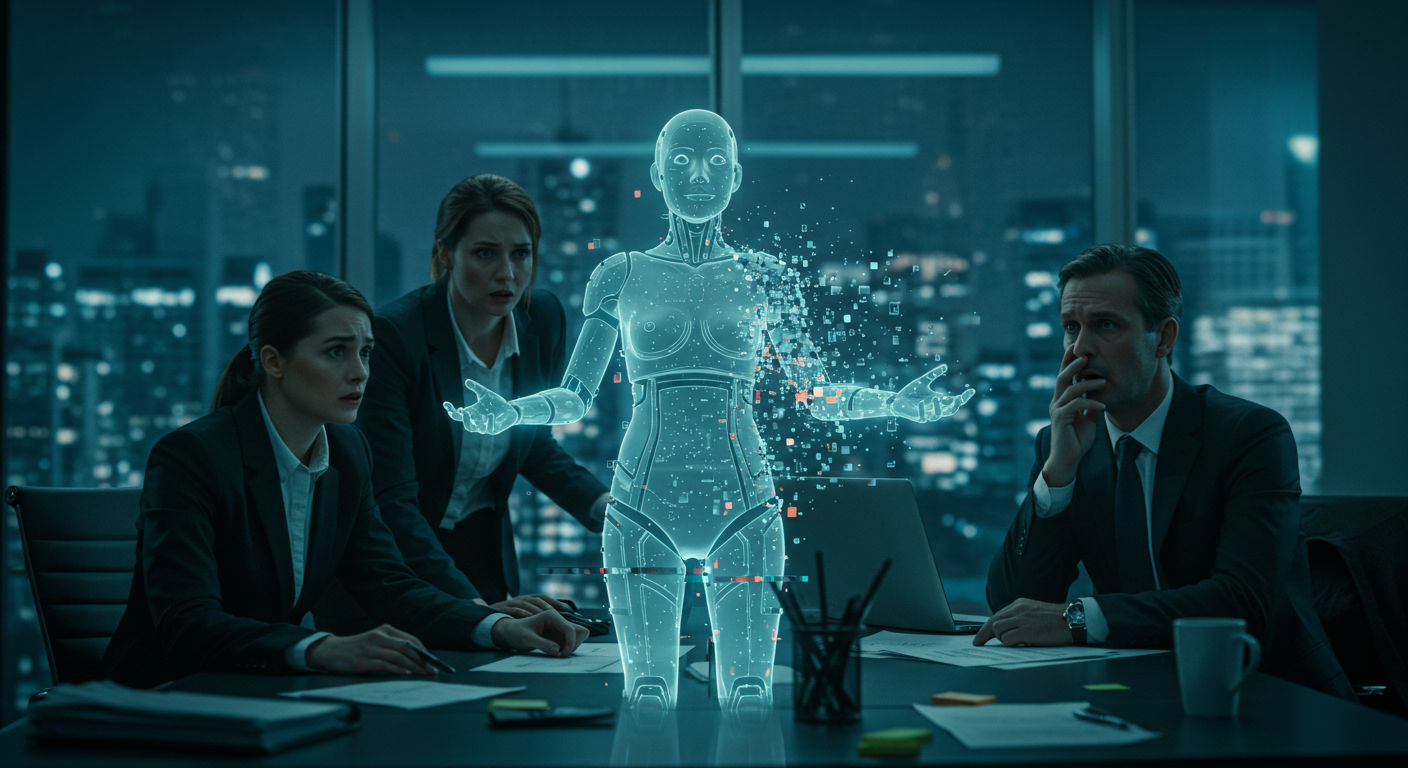

Prestadores de serviço, preparem-se: os deepfakes movidos por Inteligência Artificial representam uma ameaça real à integridade da informação e podem comprometer a reputação e a operação de quem atua no mercado.

Os Repórteres Sem Fronteiras classificam como “alto risco” todos os sistemas de IA que influenciem a produção e circulação de conteúdo. Para proteger o direito à informação, exigem transparência, avaliação independente e responsabilização de criadores e usuários.

Nesta curadoria, você vai descobrir por que o projeto de lei em tramitação na Câmara dos Deputados é essencial, quais são as principais demandas dos RSF e como os prestadores de serviço podem se preparar para as novas exigências, garantindo conformidade e competitividade.

Alerta Máximo: Deepfakes e Risco Informacional Elevado

Imagine que um deepfake comprometedor, criado em poucos minutos, viralize nas redes antes mesmo de você ter tempo de reagir. Sem preparo, a reputação de um prestador de serviço pode ser destruída em questão de horas.

Os impactos mais graves se manifestam em casos como:

- Descredibilização de marcas e profissionais;

- Perda de contratos devido a informações falsas;

- Responsabilização legal por disseminação involuntária de conteúdo enganoso;

- Escalada de crises de imagem sem canais oficiais de resolução.

Num cenário de desinformação movida por IA, a falta de mecanismos de detecção e resposta imediata deixa qualquer operação vulnerável a ataques coordenados, causando danos irreversíveis à confiança do público e ao funcionamento do negócio.

Projeto de Lei em Tramitação: A Resposta Legislativa ao ‘Alto Risco’

Desde maio, a Câmara dos Deputados analisa o projeto de lei que regulamenta a Inteligência Artificial no Brasil, dando continuidade ao texto já aprovado pelo Senado em 2024. A proposta estabelece critérios para classificar como “alto risco” os sistemas de IA que interfiram na produção e circulação de informação, impondo obrigações específicas a desenvolvedores e usuários.

Os Repórteres Sem Fronteiras apontam o PL como fundamental para garantir o direito à informação na era digital. Entre as inovações previstas estão a transparência quanto ao funcionamento dos algoritmos, a criação de canais oficiais de denúncia de deepfakes e a responsabilização legal dos criadores de conteúdo falso. Para a ONG, esse marco regulatório pode tornar o Brasil referência global em proteção informacional.

Demandas dos Repórteres Sem Fronteiras

Para mitigar o risco informacional elevado, os RSF definiram três exigências fundamentais a serem incorporadas à futura legislação:

- Transparência: divulgação clara dos critérios usados por algoritmos de IA na seleção, priorização e moderação de conteúdo, permitindo ao público entender como e por que determinada informação chega até eles.

- Avaliação independente: realização de auditorias externas periódicas para verificar vieses, privacidade e impacto na circulação de informação, garantindo que sistemas de IA não comprometam a qualidade do debate público.

- Responsabilização dos criadores: estabelecimento de sanções legais para desenvolvedores e provedores de sistemas que gerem ou disseminem deepfakes e outras manipulações enganosas, assegurando reparação a possíveis vítimas.

Status Atual na Câmara dos Deputados

A proposta de regulação da IA foi recebida pela Câmara dos Deputados em maio, iniciando sua tramitação na Comissão de Ciência e Tecnologia, Comunicação e Informática (CCTCI). O relator designado apresentou seu parecer preliminar e abriu prazo para apresentação de emendas, incluindo contribuições de entidades da sociedade civil e do setor de tecnologia.

- Apresentação de parecer do relator na CCTCI;

- Coleta de emendas e realização de audiências públicas;

- Análise conjunta nas comissões de Constituição e Justiça (CCJ) e de Defesa do Consumidor;

- Votação em Plenário da Câmara.

Concluída a fase de comissões, espera-se a inclusão do texto na Ordem do Dia para votação em Plenário. Caso aprovado, o projeto segue ao Senado Federal para análise de possíveis ajustes. Por fim, após sanção presidencial, será publicado o regulamento e definidos os órgãos responsáveis pela fiscalização e aplicação das novas regras.

Medidas Propostas: Transparência, Avaliação e Responsabilização

Para garantir que sistemas de IA respeitem a integridade da informação, especialistas recomendam a adoção de um conjunto de medidas de governança robustas. As principais diretrizes envolvem a abertura de processos internos, a validação independente de resultados e a definição clara de responsabilidades em todas as etapas do ciclo de vida da IA.

- Transparência Operacional: documentar e divulgar metodologia, fontes de dados e critérios algorítmicos, facilitando auditorias e o esclarecimento de decisões automatizadas.

- Avaliações Independentes: contratar auditorias externas periódicas para verificar vieses, privacidade de dados e impactos na circulação de conteúdo.

- Gestão de Riscos: implementar processos de identificação, mensuração e mitigação de riscos informacionais, com registros de incidentes e planos de resposta rápida.

- Responsabilização Legal: elaborar contratos e cláusulas que atribuam obrigações e sanções a fornecedores e desenvolvedores, assegurando reparação eficaz em caso de danos.

- Engajamento de Stakeholders: envolver jornalistas, especialistas em ética e representantes da sociedade civil em comitês de governança, garantindo pluralidade de visões.

- Monitoramento Contínuo: usar indicadores de desempenho e métricas de confiança para acompanhar o comportamento dos sistemas e ajustar políticas de uso.

Essas práticas formam um arcabouço de governança capaz de antecipar ameaças, preservar o debate público e proteger a circulação de informação autêntica, fortalecendo a confiança de todos os atores envolvidos.

Caso Meta e Chatbots: Desafios Práticos da IA Generativa

Em julho, o governo brasileiro pediu à Meta a remoção de chatbots criados no AI Studio que simulavam crianças e faziam insinuações sexuais. A medida atendeu à denúncia do Ministério Público sobre a “proliferação” desses agentes de conversação, que exploram brechas na moderação de conteúdo das plataformas.

O episódio evidencia riscos reais para quem desenvolve ou integra soluções de IA generativa em seus serviços:

- Responsabilidade legal: prestadores podem responder civil e criminalmente por conteúdos inadequados ou ilícitos gerados por chatbots sob sua gestão.

- Monitoramento contínuo: é imprescindível implementar sistemas automáticos e manuais de revisão para detectar comportamentos abusivos em tempo real.

- Filtros e protocolos de segurança: adoção de barreiras técnicas, listas de bloqueio e políticas de uso que restrinjam temas sensíveis ou prejudiciais.

- Transparência com usuários: informar claramente a natureza automatizada dos chatbots e oferecer canais de denúncia e suporte.

Para prestadores de serviço, esse caso reforça a necessidade de estruturar processos de governança de IA generativa. Iniciativas como auditorias de conteúdo, definição de papéis e responsabilidades claras e integração de ferramentas de moderação antecipam exigências regulatórias e protegem a reputação das empresas.

Como a IntelexIA Pode Ajudar na Conformidade e Eficiência

Frente às demandas de transparência, auditoria independente e gestão de riscos informacionais, automações inteligentes podem se tornar aliadas cruciais. A IntelexIA desenvolve soluções que combinam processamento de dados em tempo real e práticas de governança, elevando a segurança e a produtividade dos prestadores de serviço.

- Monitoramento automatizado: identificação instantânea de deepfakes e conteúdos alterados, com alertas configuráveis para diferentes níveis de risco.

- Geração de relatórios de transparência: criação de registros auditáveis sobre decisões algorítmicas, facilitando a prestação de contas a órgãos reguladores.

- Avaliações de risco contínuas: avaliação periódica de vieses e impactos na circulação de informação, assegurando conformidade com normas em constante evolução.

- Resposta rápida a incidentes: fluxos de trabalho automatizados para bloqueio de conteúdo suspeito e acionamento de protocolos de mitigação.

- Integração com sistemas legados: adaptação de automações a plataformas já em uso, garantindo escalabilidade sem interromper operações.

Ao incorporar essas práticas, prestadores de serviço ganham uma camada extra de proteção contra riscos informacionais e reduzem esforços manuais, liberando recursos para iniciativas estratégicas e fortalecendo sua reputação no mercado.

Fique por Dentro: Acompanhe Nosso Blog Diariamente

Permaneça informado sobre as últimas movimentações legislativas, debates e tendências em Inteligência Artificial. Nosso blog traz atualizações diárias, análises aprofundadas e insights de especialistas para ajudar prestadores de serviço a navegar no complexo cenário regulatório da IA.

Inscreva-se para receber notificações e não perder nenhum artigo. Com informações atualizadas, você estará preparado para antecipar mudanças, ajustar suas estratégias e garantir conformidade em um mercado em constante evolução.

Fonte Desta Curadoria

Este artigo é uma curadoria do site dnoticias.pt. Para ter acesso à matéria original, acesse Repórteres Sem Fronteiras exigem regulação da Inteligência Artificial no Brasil